大家好,今天是2024年2月24日,美西时间星期六。这里先祝大家元宵节快乐。

本期日报的主要内容,是和大家一起来阅读一下英伟达周三盘后财报的电话会议内容,着重分析黄仁勋所说“AI Tipping Point”,以及NVDA GPU芯片进军推理领域对整个行业,到底意味着什么。

NDVA对AMD构成进一步威胁

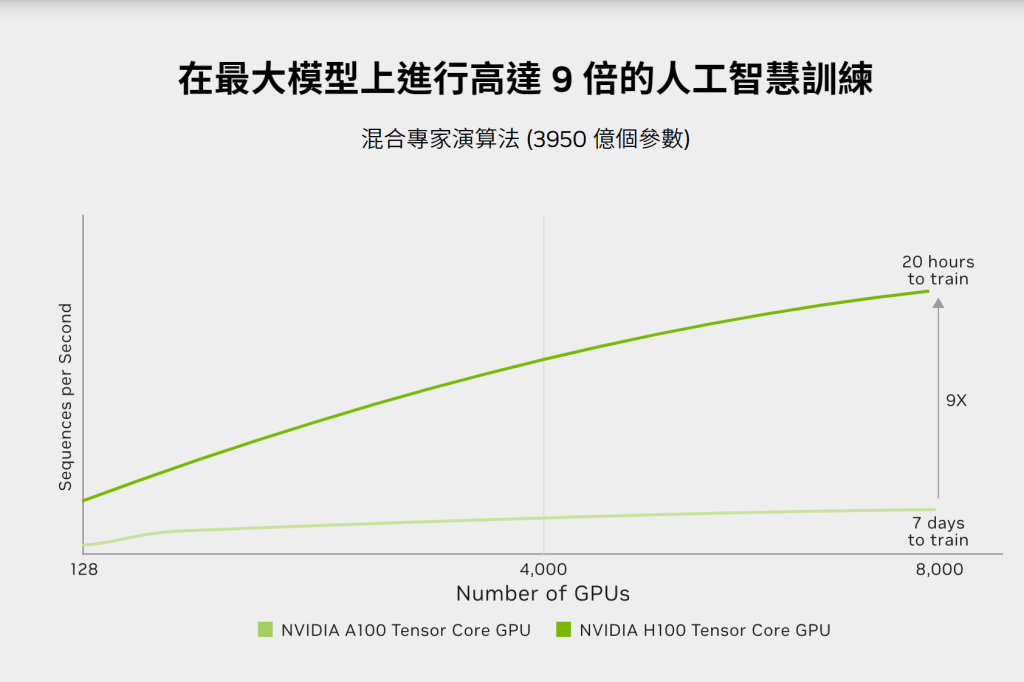

我们之前说过,AMD MX300系列芯片因为单卡显存更大,并有多家客户优化ROCm适应CUDA驱动等原因,在单卡训练性能上几乎已经接近甚至超过H100,并且AMD在推理性价比上显著超过H100:因为更大的显存意味着一张卡能够容纳更大的模型,或者用更高的精度(比如fp16而不是int8)推理一个小模型。A卡本身比N卡也会更便宜:毕竟谁能赶得上老黄家近76%的毛利率呢?

不过因为和NVIDIA的NvLink技术相比,AMD在多卡互联上依然落后,因此需要用到超过1000张显卡时,各大公司大模型的预训练(Pretraining)依然首选NVIDIA,包括最近最火的Sora也应是如此。这也是NVIDIA的超级芯片,特别是SMCI辅助出货的Gracehopper在2024年依然供不应求的原因。

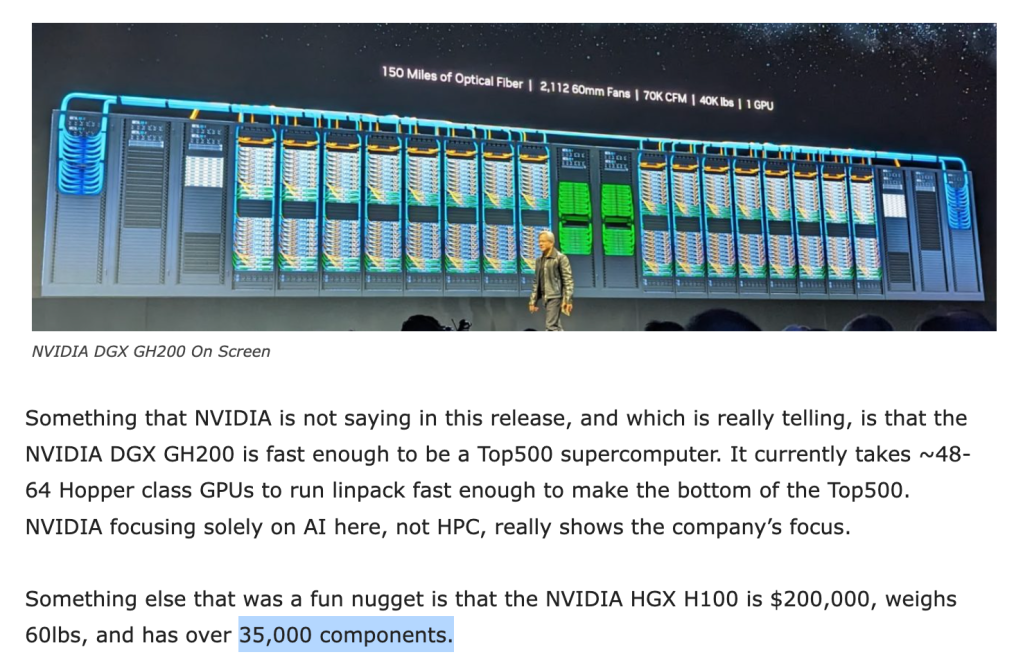

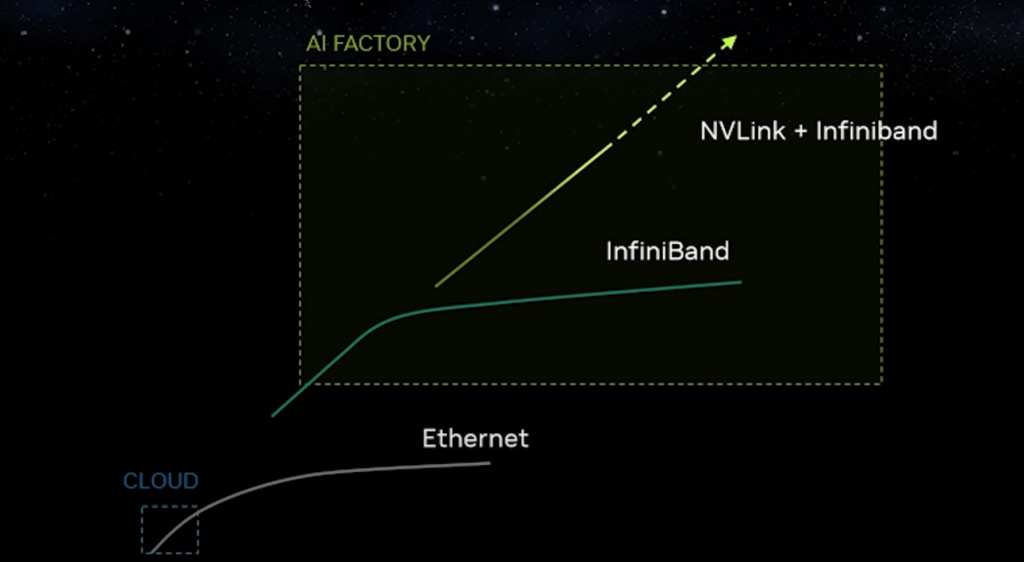

要知道,一台满载的Gracehopper服务器集群最多可以支持256块H100GPU,并且每个GPU支持18路NvLink与NVSwitch高速互联,GPU与GPU之间以900GB/s的速率通信。他实际上是一台“超级计算机”,而不仅仅是一块芯片:每台Gracehopper设备包含35000个零件,重达60磅。AMD暂时还没有相应的技术可以与之竞争,英特尔更加是被甩到车尾都看不到了。

我们认为,这种超级互联技术才是NVDA在AI数据中心真正的护城河。

NVDA的本质并不仅仅是一家显卡公司,而是“下一代基于加速的数据中心软硬件综合提供商”,他的产品包含显卡,网卡,交换机,驱动,甚至是加速软件技术栈意义上的AI操作系统。由此,我们就能理解NVDA短期内的估值恐怕并没有我们想像的那么高了。

说回主题。本来,AI芯片市场预期,可能会按照“预训练买gracehopper”,“推理——考虑到性价比和产能不足,去买AMD”的态势稳步推进,给AMD足够的机会增加市场份额。不过事情从上周起似乎就发生了变化。

首先是NVDA产能得到大幅提高。注意,这里的产能并不是台积电生产GPU的能力,GPU早已被台积电生产出来,只不过他们按照高精度高规格封装在一块gracehopper主板上,需要额外的时间和工力。在Superchip上,要将每块H100芯片按照“18路”NvLink结构实现芯片级(Chip-to-Chip)的对齐互联,其难度可想而知。因此“封装”,才是之前NVDA产能不足且出货时间高达11个月的根本原因。

然而这一切都已经发生改变。上周UBS的消息指出,NVDA的出货时间已经从11个月大幅缩减到3个月。那么为了尽快拿货而在去年下半年不得不转向AMD的众多初创公司与云服务算力,是否会改变自己的订单计划,犹未可知。

和某些分析师所认为这一消息意味着“需求见顶”的利空不同,我们认为更短的出货时间事实上有利于NVDA更快的占领市场,产能增加也将利好SMCI。作为H100和Grace Hooper的“全球唯一指定”水冷服务器供货商,我相信SMCI未来几个季度的销售指引恐怕又要被大幅提高了。不过因为这家公司的股价最近波动率比较大,我本人不会在确定性事件出来之前追高。如果能有机会跌到600区间,我可能会考虑抄底。具体的操作请移步文末会员区。

NVDA可能会推出推理(Inference)专用产品

对AMD威胁最大的,还不仅仅是NVDA突然飙升的产能。在财报后的电话会议里,我们注意到英伟达CEO和分析师之间的这样一段对话:

- “我们的训练集群可以迅速变成推理集群”,这也是NVDA通用计算GPU芯片和其他“脆弱”的ASIC芯片最大不同之处,他的用途可以随着产业发展阶段的不同而改变

- AI产业链进入了从重预训练第一阶段,到重推理第二阶段的过渡

- 这也就意味着,AI应用落地事实上已经开始,市场对于AI无法落地风险的担忧正在被迅速消除。大批成熟的应用正逐渐走向消费者并开始变现,比如Github Copilot,Office 365 AI,Sora,Perplexity等。

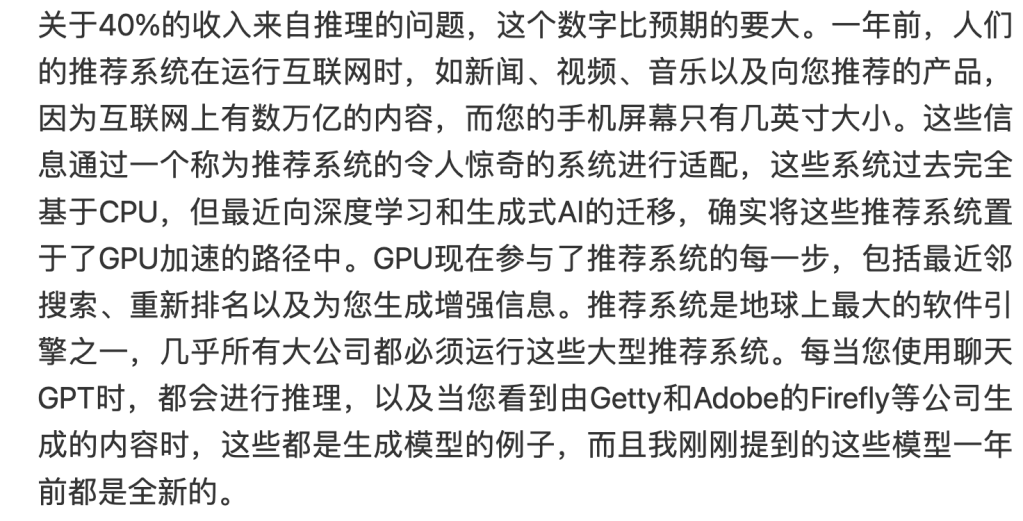

- “我们推理业务占NVDA收入的40%”也佐证了这一论断

- 不仅如此,NVDA还认为,自己的GPU技术将会成为未来个人AI电脑和AI手机终端的核心

这表明,NVDA已经有决心全面进军推理领域,应对未来预训练市场的饱和状态。而这将对AMD构成严重挑战。

推理GPU和训练GPU不同,因不需要反向传播,以及模型的权重已经确定,芯片电路的成本与性能优化的空间实际上会更大。考虑到NVDA在CUDA、芯片设计、芯片互联方面几乎压倒性的优势,我们认为,NVDA近期推出一款专门为推理而生的全新GPU芯片的可能性大大提高。这款新品可能会有超高的推理速度和极高的性价比,而这种产品,对于刚刚在AI芯片上站稳脚跟的AMD将是毁灭性的。因为AMD主力产品现在的优势,除了性价比之外,就是在于推理。

我们认为,这一全新的面向推理的GPU产品,很可能就会在NVDA三月底的GTC会议上提出。投资者们需要面对这一可能发生的行业变局作出反应,正确决策。

基于推理的AI个人电脑时代到来,还有谁会因此受益?

如果说未来每个人的电脑、手机和一切终端设备,都会变成运行Transdformer的LLM推理机,那么能因此趋势受益的,除了NVDA,应该至少还有另外一家硬件公司:

我们认为,那家公司就是苹果。

在今年的WWDC 24大会上,苹果极有可能宣布自己的Macbook和iPhone设备中将内置大语言模型加速,为用户提供本地的人工智能服务,特别是Siri 2.0。

想象一下,在自己手机上免费,或者通过Apple One订阅使用chatGPT的场景吧?

已经有人测试,得益于庞大的统一内存(Unified Memory)——还记得我们之前提到的,大显存有利于推理大模型吗?通过一些量化技巧,苹果的M系列芯片已经可以在本地运行较有竞争力的LLAMA2或Mistral 7b模型了。我们相信,苹果硬件团队为加速GPT推理而在自家M和A系列芯片中加入一块全新的transformer-NPU,将不是什么难题。考虑到苹果在芯片设计上的技术实力,为了LLM做一个ASIC,也不是完全不可能。

一旦苹果决定利用自己在终端上庞大的产品生态和近乎垄断的地位亲自下场,这对AIGC最终落地走进千家万户将会起到决定性作用,恐怕也会开启一轮全新的App变现浪潮。整个AI产业的规模还将继续扩大,对整个板块都将是利好。苹果或许也能借此扭转自己因为“缺乏创新”而出现的销量颓势,增加Siri的实用性,改进AI服务生态,股价将有机会出现大幅反弹。

我们将我们的应对决策整理总结如下,包含对NVDA,AMD,AAPL,SMCI和其他相关股票个人操作策略的看法。请按屏幕提示或者阅读本文了解会员项目,继续阅读本站全部会员可见文章,也可加入我们的会员群进行更为深入的讨论。

股市有风险,投资需谨慎,下述意见仅供参考:

《“周末分享:英伟达进军推理,对市场意味着什么?AI领域我认为会出现基本面变化的两家公司,我下周的投资计划小结”》 有 4 条评论